Webアプリケーションのセキュリティを学ぶ上で、今週は非常に濃密な一週間だったことと思います。HTTP/HTTPSの基礎から始まり、SQLインジェクション、クロスサイトスクリプティング(XSS)、CSRF、そしてディレクトリトラバーサルやセッションハイジャックといった、Webサイトを脅かす主要な攻撃手法について詳しく見てきました。

これら一つひとつの攻撃手法を手動で探し出し、対策を行うことはもちろん重要です。しかし、数百、数千のページを持つ大規模なWebアプリケーションに対して、すべての入力フォームを手動でテストすることは現実的ではありません。そこで登場するのがWeb脆弱性診断ツール(スキャナ)です。

今回は、今週学んだ攻撃手法の知識を総動員し、それらを「どうやって効率的に発見するか」という視点で、Web脆弱性診断ツールの仕組みと活用方法を徹底解説します。セキュリティエンジニアとして現場に出た際、必ずと言っていいほど触れることになるこの技術。ツールの裏側でどのような通信が行われているのかを理解することで、これまでの学習内容が「点」から「線」へと繋がるはずです。

脆弱性診断ツールが必要とされる背景と役割

なぜ、私たちはツールを使う必要があるのでしょうか。それは「網羅性」と「効率性」のバランスを保つためです。

Webアプリケーションは日々更新され、機能が追加されていきます。そのたびにセキュリティ専門家がすべてのコードを目視確認したり、手動で攻撃コードを入力したりしていては、開発スピードに追いつけません。また、人間がチェックする場合、どうしても見落とし(ヒューマンエラー)が発生します。

脆弱性診断ツールは、プログラムされたルールに基づいて機械的に検査を行うため、基本的な脆弱性の洗い出しを高速かつ大量に行うことができます。特に定期的なセキュリティ監査やCI/CDパイプラインへの組み込みにおいて、自動化されたツールは不可欠な存在となっています。

自動診断と手動診断の使い分け(試験のツボ)

ただし、ツールは万能ではありません。SC試験の午後問題でも、「ツールで発見できるもの」と「人間が判断すべきもの」の違いは頻出のテーマです。

自動診断(ツール)が得意な領域: 既知のパターン(シグネチャ)マッチング、SQLインジェクションやXSSなど、リクエストとレスポンスの形式的な矛盾から発見できる脆弱性、HTTPヘッダの不備(HSTSやX-Frame-Optionsの欠如など)といった技術的な問題を高速に検出できます。

手動診断(専門家)が必要な領域: 仕様上の不備(論理的脆弱性)には専門家の介入が必須です。例として、「意図しない安価な価格で商品が購入できる」「他人の注文履歴が見えてしまう」といった、アプリケーションのビジネスロジックに起因する問題があります。これらはエラーが出ないため、ツールでは「正常」と判定されてしまいます。また、複数の機能を特定の順序で操作した時だけ発生するようなバグも、手動診断でなければ発見できません。

この両輪を回すことが、現代のWebセキュリティには不可欠です。実際のセキュリティ診断プロジェクトでは、まずツールで全体をスキャンし、検出された問題を手動で精査し、さらに重要な機能については専門家が独自のテストケースを作成して検証するという流れが一般的です。

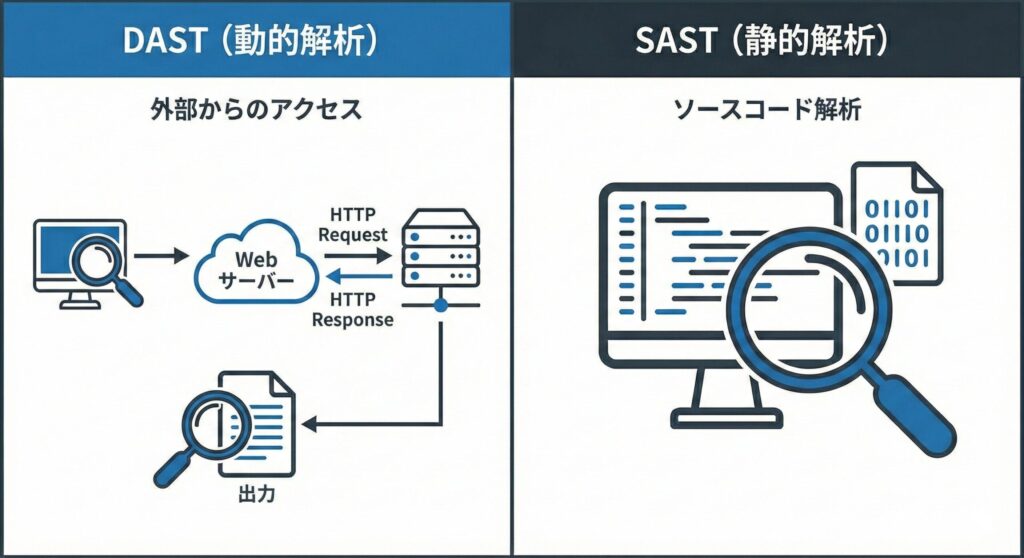

診断ツールの種類: DASTとSASTの違い

Web脆弱性診断ツールには、大きく分けて2つのアプローチがあります。試験対策として、また実務でのツール選定の基準として、この違いを明確に理解しておきましょう。

1. DAST(Dynamic Application Security Testing)

動的アプリケーションセキュリティテスト。別名「ブラックボックステスト」とも呼ばれます。

実際に稼働しているWebアプリケーション(ステージング環境や本番環境)に対して、外部からブラウザ(クライアント)のふりをしてHTTPリクエストを送信し、返ってくるレスポンスの内容から脆弱性を判定します。実際の通信経路を通るため、WAF(Web Application Firewall)やロードバランサの設定不備も含めた、より現実的な攻撃シミュレーションが可能です。

代表的なツールには、OWASP ZAP、Burp Suite Professional、Vexなどがあります。これらは1/15に学んだ「HTTPリクエスト/レスポンス」の構造を解析して診断を行います。DASTの利点は、プログラミング言語やフレームワークに依存せず、Webアプリケーションとして動作している限り診断できる点です。

2. SAST(Static Application Security Testing)

静的アプリケーションセキュリティテスト。別名「ホワイトボックステスト」とも呼ばれます。

アプリケーションを動かすことなく、ソースコードそのもの(Java、PHP、Pythonなど)を解析して、コーディングの不備や脆弱な関数の使用を検出します。開発の早い段階(コーディング中)に問題を発見できるため、修正コストを抑えられます。これは「シフトレフト」と呼ばれる、セキュリティをより早期の開発段階に組み込む考え方の中核をなします。

代表的なツールには、SonarQube、Fortify、Checkmarxなどがあります。これらは1/17に学んだ「プレースホルダを使わず文字列結合しているSQL文」などをコードレベルで指摘します。SASTの特徴は、コンパイル前の段階でチェックできるため、リリース前に問題を修正できる点です。

実務では、これらを組み合わせた「ハイブリッドアプローチ」が推奨されます。SASTで開発段階の問題を早期に発見し、DASTでデプロイ後の実環境での動作を検証するという二段構えです。さらに、IAST(Interactive Application Security Testing)という、アプリケーション内部にエージェントを埋め込んで動的にテストする手法も登場しています。

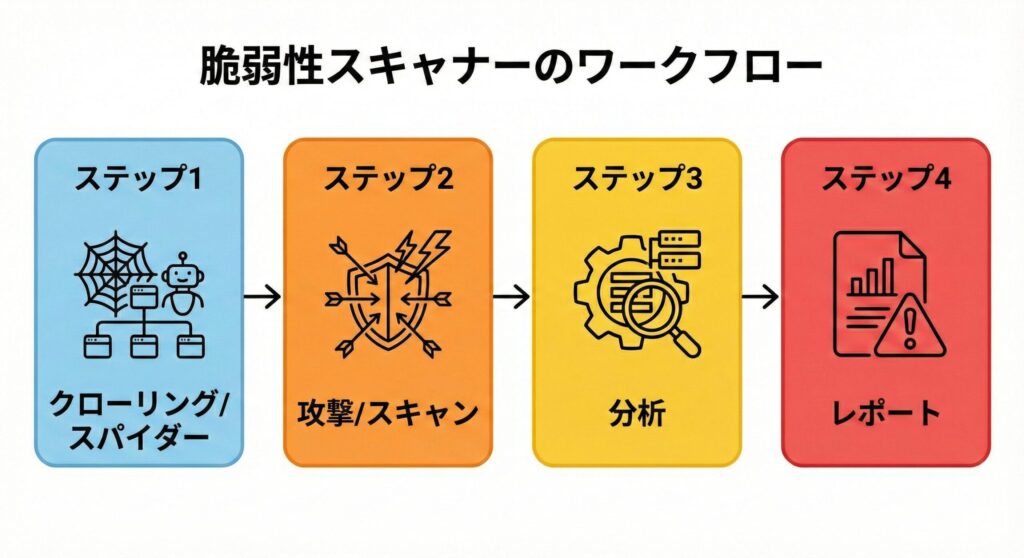

診断ツールの基本的なワークフロー

実際の診断ツール(例: OWASP ZAP)は、以下のような流れで診断を行います。このプロセスは大きく「クローリング」と「スキャニング」という2つのフェーズに分かれます。

フェーズ1: クローリング(探索)

診断対象のWebサイトの全貌を把握するフェーズです。ツールに含まれる「スパイダー(Spider)」と呼ばれる機能が、TOPページからリンクを順に辿り、サイト内のURL、パラメータ、フォームの場所をリストアップします。これを「サイトマップ」として構築します。

クローリングの精度は診断結果の網羅性に直結します。ここで発見できなかったページは診断されません。JavaScriptで動的に生成されるリンクや、ログインが必要な奥まったページは、ツールが辿れないことがあります。そのため、手動でブラウザを操作し、ツールに通信を学習させる(プロキシとして通す)工程が重要になります。

現代のWebアプリケーションでは、Single Page Application(SPA)が増加しており、従来のHTMLパースだけでは不十分なケースが増えています。このため、最新のツールではヘッドレスブラウザを利用してJavaScriptを実行しながらクローリングする機能が標準化されつつあります。

フェーズ2: スキャニング(診断・攻撃)

リストアップされたURLに対し、実際に擬似的な攻撃リクエストを送信するフェーズです。これを「アクティブスキャン」と呼びます。ツールは数千種類の攻撃パターンを持っており、各エンドポイントに対して体系的にテストを実行します。

スキャニングでは、パラメータの型や長さを変更したり、特殊文字を挿入したり、境界値テストを行ったりします。例えば、数値を期待するパラメータに文字列を送信したり、最大長を超える文字列を送信したりして、アプリケーションの反応を観察します。

アクティブスキャンは実際に大量の攻撃データを送りつけるため、データベースにゴミデータが登録されたり、フラグが書き換わってシステムが停止したりするリスクがあります。必ず許可を得た検証環境で行うのが鉄則です。本番環境で無断で行うと、不正アクセス禁止法に抵触する恐れすらあります。また、メール送信機能などがある場合、テストデータによって大量のメールが送信されてしまうこともあるため、事前に通知機能を無効化するなどの配慮が必要です。

今週の「敵」をツールはどうやって見つけるのか?

ここからは、今週学んだ具体的な攻撃手法に対し、DAST(動的診断ツール)がどのようなアプローチで検知を試みるのか、そのメカニズムを深掘りします。この理解は、午後試験で「攻撃の痕跡(ログ)」を読み解く際にも非常に役立ちます。

1. SQLインジェクションの検知(1/16の復習)

SQLインジェクションは、データベースを不正に操作する攻撃でしたね。診断ツールは、入力フォームやURLパラメータに対して、データベースのエラーを誘発するような特殊文字(メタ文字)を大量に送信します。

ツールの挙動例:

通常のリクエストはhttp://example.com/item?id=10のような形式です。これに対し、診断リクエストではhttp://example.com/item?id=10'のようにシングルクォートを付与します。

判定ロジックとして、レスポンスに「SQL Syntax Error」や「ORA-XXXX」といったデータベース由来のエラーメッセージが含まれているかをチェックします。これはError-basedと呼ばれる検知手法です。また、ページの内容が極端に変化していないかも確認します。

高度な検知(Blind SQL Injection): エラーメッセージが出ない設定になっている場合、ツールは「時間差」を利用します。これはTime-based Blind SQLiと呼ばれる手法です。

ペイロード例として、1'; WAITFOR DELAY '0:0:5'--(SQL Server)や1' AND SLEEP(5)--(MySQL)があります。検知ロジックとしては、通常0.1秒で返るレスポンスが、この値を送った時だけ5秒以上かかった場合、「DBがSLEEPコマンドを実行した=脆弱性あり」と判断します。

さらに高度なBoolean-based Blind SQLiでは、真偽を返す条件式を送信し、レスポンスの違いからデータベースの内容を1ビットずつ推測していきます。例えば、1' AND (SELECT COUNT(*) FROM users) > 10--のような条件式を送り、ページの表示が変わるかどうかで、usersテーブルのレコード数が10より大きいかを判定します。

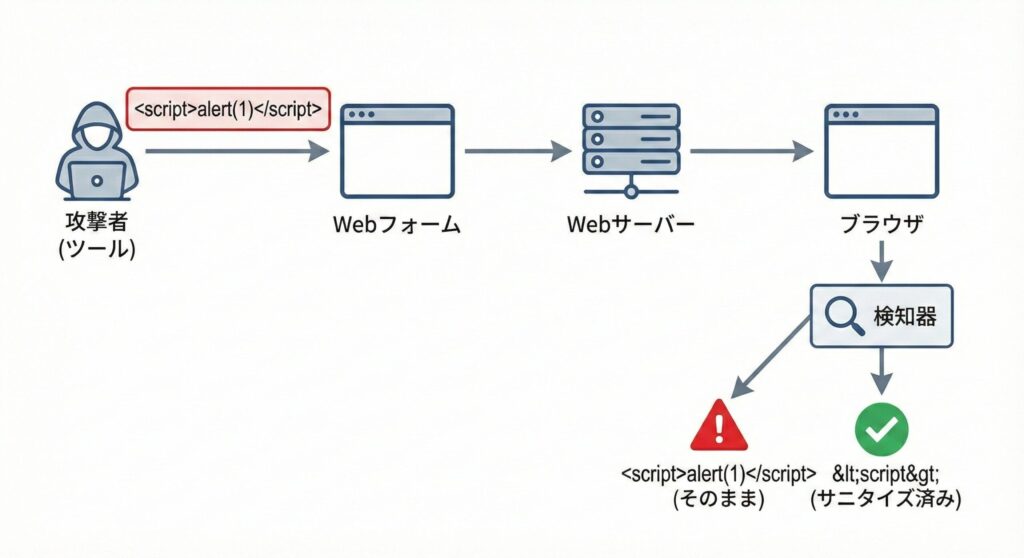

2. クロスサイトスクリプティング(XSS)の検知(1/17の復習)

XSSは、悪意のあるスクリプトがブラウザ上で実行されてしまう脆弱性です。ツールは、入力値が適切にエスケープ(無害化)されずにそのまま出力されているかを確認します。

ツールの挙動例:

診断リクエストとして、検索ボックスなどに<script>alert(1)</script>や"><img src=x onerror=alert(1)>といった特徴的な文字列(テストシグネチャ)を送信します。

判定ロジックとして、レスポンスボディ(HTMLソース)の中に、送信した文字列がそのままの形で存在しているかをチェックします。<script>のようにサニタイズ(無害化)されていれば「脆弱性なし」と判断します。

XSS検知では、単純なスクリプトタグだけでなく、さまざまなバイパステクニックも試されます。例えば、大文字小文字の混在(<ScRiPt>)、エンコード(%3Cscript%3E)、イベントハンドラ(onload=、onerror=)、HTMLエンティティ、Unicode文字など、フィルタを回避する多様なパターンが使用されます。

3. ディレクトリトラバーサルの検知(1/19の復習)

サーバー内の非公開ファイルにアクセスする攻撃です。

ツールの挙動例:

診断リクエストとして、ファイル名を指定するパラメータに対し、../../../../etc/passwdや..\..\windows\win.iniを送信します。

判定ロジックとして、レスポンスに「root:x:0:0...」のようなパスワードファイル特有のパターン文字列が含まれているかをチェックします。また、HTTPステータスコードが200(成功)で返ってきているかも確認します。

ディレクトリトラバーサルの検知では、パス区切り文字のバリエーション(/、\)、URLエンコード(%2e%2e%2f)、二重エンコード(%252e%252e%252f)なども試されます。また、Windowsの代替データストリーム(ADS)や、Linuxのシンボリックリンクを悪用した攻撃パターンも含まれます。

4. CSRF(クロスサイトリクエストフォージェリ)の検知

CSRFは、ユーザーの意図しない操作を強制的に実行させる攻撃です。

診断ツールは、重要な操作(パスワード変更、商品購入など)を行うリクエストに対して、CSRFトークンが適切に実装されているかを検証します。具体的には、正規のリクエストからCSRFトークンを削除したり、別セッションのトークンに置き換えたりして送信し、それでも処理が成功してしまうかを確認します。

また、Refererヘッダーのチェックが適切に行われているか、SameSite Cookie属性が設定されているかなども診断項目に含まれます。

5. セッションハイジャックとセッション管理の検証

セッション管理の脆弱性も診断ツールの重要なチェック項目です。

セッションIDの予測可能性、セッションIDがURLに含まれていないか、HTTPSでSecure属性が設定されているか、HttpOnly属性が設定されているか、セッションタイムアウトが適切か、ログアウト後にセッションが無効化されるかなど、多角的に検証します。

ツールは、複数のブラウザから同時にアクセスしてセッションIDの生成パターンを解析したり、セッション固定攻撃(Session Fixation)が可能かをテストしたりします。

誤検知(False Positive)と検知漏れ(False Negative)

ツールを利用する上で避けて通れないのが、「誤検知」と「検知漏れ」の問題です。試験でも「セキュリティ管理者の対応」としてよく問われます。

誤検知(False Positive)

脆弱性がないのに、あると判定してしまうことです。

例えば、エラーページにたまたま「SQL」という解説文が含まれていただけで、SQLインジェクションありと判定するケースがあります。また、セキュリティに関する教育コンテンツを提供しているサイトでは、XSSの説明として<script>タグの例が掲載されているため、誤検知が頻発します。

エンジニアは、ツールの結果を鵜呑みにせず、「本当に攻撃が成立するのか?」を手動で検証(再現確認)して精査する必要があります。これを「トリアージ」と呼びます。トリアージでは、検出された脆弱性の真偽だけでなく、ビジネスへの影響度、修正の優先順位なども判断します。

誤検知を減らすためには、ツールのチューニングが重要です。例えば、特定のURLパターンを除外したり、コンテキストに応じた検知ルールを設定したりします。また、ベースラインスキャン(正常な状態をあらかじめ記録しておく)を行うことで、新たに発生した問題だけを抽出することも効果的です。

検知漏れ(False Negative)

脆弱性があるのに、ないと判定してしまうことです。

これは非常に危険な状態です。例えば、特殊な手順を踏まないと表示されない画面や、複雑なマルチステップの処理にある脆弱性、CSRFトークンの検証漏れ、レースコンディション、タイミング攻撃などは、標準的なスキャンでは発見できないことがあります。

また、WAFやIPSによってツールからの攻撃が遮断されていると、脆弱性が存在していても「問題なし」と誤判定されることがあります。このため、診断時にはWAFを一時的に無効化するか、ツールのIPアドレスをホワイトリストに登録する必要があります。

検知漏れを防ぐために、自動ツールの限界を理解し、重要な機能(決済処理、認証処理など)については必ず専門家による手動診断を組み合わせるのです。特に、ビジネスロジックの脆弱性、権限制御の不備、APIの認証・認可の問題などは、人間の思考と創造性が必要な領域です。

代表的なツール: OWASP ZAPとは

情報処理安全確保支援士の試験対策として、また実務での入門用として最も重要なツールがOWASP ZAP(Zed Attack Proxy)です。

特徴

オープンソース: 無料で利用可能です。世界中のセキュリティ専門家がコミュニティとして開発・保守しており、定期的にアップデートされます。

プロキシ型ツール: ブラウザとサーバーの間に立ち、通信を傍受・改ざんします。この仕組みにより、ブラウザから送信される実際のHTTPリクエストを詳細に観察し、パラメータを自由に変更してテストできます。

多機能: Spider機能でサイト構造の自動探索を行い、Active Scanで脆弱性スキャンを実施します。さらにFuzzing機能により、特定のパラメータに大量のテストデータを送りつけることができます。

その他にも、Passive Scan(通信を監視するだけで脆弱性を検出)、手動での通信操作(Repeater、Manual Request Editor)、スクリプト機能(Python、JavaScriptによる自動化)、レポート生成機能なども備えています。

試験での出題イメージ

午後試験では、OWASP ZAPのようなプロキシツールの画面キャプチャや、そこから出力されたHTTPリクエストのログが表示されることがあります。「このリクエストは何を意図しているか(SQLi狙いか、XSS狙いか)?」や「このレスポンスから読み取れる脆弱性は何か?」を問われます。

例えば、問題文に「診断ツールのログにid=1' OR '1'='1というパラメータが記録されていた」という記述があれば、これはSQLインジェクションの診断を行っていたことが推測できます。また、「レスポンスに5秒の遅延が発生した」という記述があれば、Time-based Blind SQLiの検証を行っていたと判断できます。

今週学んだ各攻撃手法の「リクエストの形」を頭に描けるようにしておくことが、合格への近道です。特に、攻撃ペイロードの特徴的なパターン(シングルクォート、スクリプトタグ、パストラバーサルの../など)を覚えておくと、ログ解析問題で有利になります。

専門性を深める: CVSSとスコアリングの裏側

脆弱性診断ツールが問題を検出した際、その深刻度をどのように判断しているのでしょうか? ここでは、診断レポートなどで必ず目にする「CVSS」について、ツールの観点から補足します。

CVSSの基本構成

CVSS(Common Vulnerability Scoring System)は、脆弱性の深刻度を同一の基準で定量的に評価する仕組みです。SC試験でも午前・午後問わず頻出です。診断ツールが出力するレポートは、基本的にこのCVSSスコアに基づいて「High」「Medium」「Low」といったリスクレベルを表示します。

基本評価基準(Base Metrics): ツールが自動判定できるのは主にここです。脆弱性そのものの特性を評価します。

攻撃元区分(AV: Attack Vector)では、ネットワーク経由で攻撃可能か判断します。Web脆弱性はほぼ「ネットワーク」に分類されます。攻撃条件の複雑さ(AC: Attack Complexity)では、攻撃成立に特殊な条件が必要かを評価します。必要な特権レベル(PR: Privileges Required)では、ログインが必要か、管理者権限が必要かを判定します。ユーザ関与レベル(UI: User Interaction)では、XSSのように、ユーザがリンクをクリックする必要があるかを確認します。

影響度(C、I、A)では、機密性(Confidentiality)、完全性(Integrity)、可用性(Availability)への影響を評価します。例えば、SQLインジェクションはデータベースの全データが漏洩する可能性があるため、機密性への影響が「High」と評価されます。

ツール判定のロジックと現実のズレ

例えば、ツールが「SQLインジェクションの疑いあり」と検知した場合、データベースの中身が丸見えになる可能性があるため、CVSSの基本値は非常に高く(9.0〜10.0など)算出されます。

しかし、実際にはWAFが導入されていたり、データベースの権限が適切に絞られていて重要なテーブルにはアクセスできなかったりするケース(現状評価基準)もあります。ツールはあくまで「脆弱性が存在する事実」と「一般的な脅威度」を示すだけであり、自社のビジネスにとってどれだけ危険かまでは判断してくれません。

ここにも、人間のエンジニアによる「リスク評価」の重要性があります。診断結果を受け取った後、「このサーバーは外部に公開されていないから、優先度を少し下げよう」といった判断や、「個人情報が入っているDBだから、スコア以上に最優先で直そう」といった判断が必要になるのです。

CVSS v3.1では、現状評価基準(Temporal Metrics)と環境評価基準(Environmental Metrics)も定義されています。現状評価基準では、攻撃コードの利用可能性、修正プログラムの有無、脆弱性情報の信頼性などを考慮します。環境評価基準では、組織にとっての機密性、完全性、可用性の重要度を反映させます。

ステートフルな診断と認証スキャン

Webアプリケーション診断で最もつまずきやすいのが、「ログイン後のページ」の診断です。これを技術的に深掘りします。

セッション維持の難しさ

通常のWebクローラは、リンクを辿るだけですが、会員制サイトの場合、ログインフォームにID/PASSを入れて認証を通過し、サーバーから発行されたセッションID(Cookie)を保持し続けなければなりません。

診断ツール設定のキモはここにあります。

ログインマクロの作成: ツールに「ログイン画面を開く」→「IDを入れる」→「PASSを入れる」→「ボタンを押す」という一連の動作を記録させます。OWASP ZAPでは、この操作を「Authentication」設定で定義します。

ログアウト検知: 診断中に誤って「ログアウト」ボタンのリンクを踏んでしまうと、セッションが切れ、以降の診断が無効になってしまいます。これを防ぐため、ツールには「ログアウト機能のURLを除外する」設定や、「特定のキーワード(例: ログインしてください)がレスポンスに含まれたら、再ログイン処理を行う」という設定が必要です。

SC試験の午後問題でも、「診断を実施したが、ログイン後のページが検査されていなかった。原因は何か?」という趣旨の設問が出ることがあります。答えは往々にして「セッション管理の設定不備」や「ログアウトリンクの誤踏み」です。

実際の診断では、ユーザー権限ごとに診断を実施する必要があります。一般ユーザー、管理者、モデレーターなど、それぞれの権限で異なる機能にアクセスできるため、権限昇格の脆弱性を発見するには、複数のアカウントでのスキャンが不可欠です。

近年の診断トレンド: API診断とSPA

Web技術の進化に伴い、診断ツールのトレンドも変化しています。これも押さえておきましょう。

SPA(Single Page Application)の診断

ReactやVue.jsなどで作られたモダンなWebアプリ(SPA)は、画面遷移をせずJavaScriptで動的にコンテンツを書き換えます。従来の「HTMLを解析してリンクを辿る」タイプのクローラでは、SPAの構造を正しく認識できません。

これに対応するため、最新のDASTツールは、ヘッドレスブラウザ(GUIを持たないChromeなど)を内蔵し、実際にJavaScriptを実行・レンダリングしながらクロールする機能(DOM Crawling)を強化しています。

SPAでは、クライアントサイドのルーティングが使われるため、URLが変化せずに画面が切り替わることがあります。このような場合、ツールはDOMの変化を監視し、新しいコンテンツが表示されたことを検出してスキャンを続行します。

また、WebSocketやServer-Sent Events(SSE)を使ったリアルタイム通信も増えており、これらのプロトコルに対応した診断ツールも登場しています。

Web API(REST/GraphQL)の診断

スマホアプリのバックエンドや、マイクロサービス化に伴い、Web APIの診断重要度が増しています。

APIには「画面」がないため、従来のクローラは機能しません。そこで、APIの設計図である「OpenAPI(Swagger)定義ファイル」をツールに読み込ませ、そこから自動的にテストリクエストを生成・送信する機能が一般的になっています。

GraphQLの場合、Introspectionクエリを利用してスキーマを自動取得し、全エンドポイントを網羅的にテストすることができます。ただし、本番環境でIntrospectionが有効になっていること自体がセキュリティリスクとなるため、注意が必要です。

「APIセキュリティ」はSC試験でも新しいトピックとして注目されています。入力値検証の甘さによるMass Assignment脆弱性(クライアントから送信された予期しないパラメータがそのままオブジェクトに代入されてしまう問題)などをツールでどう検知するか、という視点も持っておくと良いでしょう。

APIセキュリティでは、認証・認可の不備、過度なデータ露出、レート制限の欠如、不適切なリソース管理なども重要な診断項目です。OWASP API Security Top 10が参考になります。

実践的な診断のベストプラクティス

診断ツールを効果的に活用するためのベストプラクティスをまとめます。

診断前の準備

スコープの明確化: 診断対象のURLやIPアドレス範囲を明確にし、許可を得ます。対象外のシステムに誤ってアクセスしないよう、ツールの設定で範囲を制限します。

テストアカウントの準備: 様々な権限レベルのアカウントを用意し、それぞれで診断を実施します。本番データを持つアカウントは使用しません。

バックアップの取得: 万が一の場合に備え、診断前にデータベースやファイルシステムのバックアップを取得します。

関係者への通知: 診断によってシステムに負荷がかかることや、大量のログが記録されることを関係者に事前通知します。

診断中の注意点

段階的なアプローチ: いきなり全機能のアクティブスキャンを実行するのではなく、まずPassive Scanで通信を観察し、その後限定的なActive Scanを行い、問題がないことを確認してから全体スキャンを実施します。

ログの監視: 診断中はサーバーログやアプリケーションログを監視し、異常な動作がないか確認します。エラーが頻発する場合は、スキャンを一時停止して原因を調査します。

時間帯の考慮: 本番環境に近い環境で診断する場合、業務時間外や週末など、影響が少ない時間帯を選びます。

診断後のフォローアップ

結果の精査: 誤検知を除外し、本当の脆弱性だけをリストアップします。各脆弱性について、再現手順、影響範囲、修正方法を文書化します。

優先順位付け: CVSSスコアだけでなく、ビジネスへの影響、攻撃の容易さ、データの重要性などを考慮して、修正の優先順位を決定します。

修正の検証: 脆弱性を修正した後、再度診断を実施して、問題が解決されていることを確認します。これを「再テスト」または「リグレッションテスト」と呼びます。

診断ツールの限界と人間の役割

診断ツールは強力ですが、万能ではありません。ツールの限界を理解し、人間のエンジニアが補完する必要があります。

ビジネスロジックの脆弱性: 「クーポンを複数回使用できてしまう」「ポイント計算のバグで不正に利益を得られる」といった問題は、アプリケーションの仕様を深く理解しないと発見できません。

コンテキストの理解: ツールは技術的な脆弱性を検出しますが、それがビジネスにとって本当に重要かどうかは、人間が判断する必要があります。例えば、開発用の内部サイトのXSSと、顧客向けECサイトのXSSでは、リスクの重みが全く異なります。

創造的な攻撃: 攻撃者は常に新しい手法を考案しています。ツールのシグネチャに含まれていない最新の攻撃手法に対しては、セキュリティ研究者の知識と経験が必要です。

複合的な攻撃シナリオ: 複数の脆弱性を組み合わせた攻撃(例: CSRFとXSSを組み合わせてアカウントを乗っ取る)は、ツールでは検出が困難です。

したがって、理想的なセキュリティ診断は、「ツールによる自動診断」と「専門家による手動診断」を組み合わせたハイブリッドアプローチです。ツールで基本的な脆弱性を効率的に洗い出し、人間がビジネスロジックや複雑な攻撃シナリオを検証する、という役割分担が重要です。

まとめ: ツールは「魔法の杖」ではない

今回は、今週学んだWebセキュリティの知識をベースに、Web脆弱性診断ツールの仕組みについて解説しました。

重要なポイントを振り返ります。

自動化の必要性: 膨大なページを網羅的に検査するために、DAST(動的診断)などのツールは不可欠である。開発サイクルが高速化する現代において、継続的なセキュリティテストを実現するには、自動化が欠かせません。

検知の仕組み: ツールは「正常なリクエスト」と「攻撃パターン(シグネチャ)」を比較し、レスポンスの違いやエラーメッセージから脆弱性を判定している。SQLインジェクション、XSS、ディレクトリトラバーサルなど、今週学んだ各攻撃手法に対応した検知ロジックが実装されています。

ツールの限界: 誤検知や検知漏れは必ず発生する。最終的な判断は、エンジニアの知識と手動検証にかかっている。特にビジネスロジックの脆弱性や複合的な攻撃シナリオは、人間の創造性と深い理解が必要です。

OWASP ZAP: 試験対策としても実務としても、このツールの挙動やログの見方を理解しておくことは非常に価値がある。オープンソースで無料なので、実際に触れて学習することが可能です。

CVSSと優先順位付け: 脆弱性の深刻度を定量的に評価するCVSSを理解し、自社のビジネスコンテキストに応じたリスク評価を行うことが重要です。

今週一週間で、「攻撃の手口」と「守りの基礎」、そして「発見する方法」までを一通り網羅しました。これらはWebセキュリティの根幹をなす部分です。

来週はいよいよ、さらに深刻かつ具体的な「サイバー攻撃手法の詳細」に踏み込みます。マルウェア、ランサムウェア、標的型攻撃など、ニュースでもよく耳にする脅威の深層に迫ります。ここまでのWebの知識がベースにあれば、よりスムーズに理解できるはずです。

週末は、ぜひご自身のPCにOWASP ZAPをインストールして(※スキャンは必ず自分の管理下のローカル環境に対してのみ行ってください!)、実際にHTTPリクエストが飛ぶ様子を眺めてみてください。画面上の文字としての知識が、一気にリアルな体験として定着するはずです。

それでは、また次回の学習でお会いしましょう!

振り返りチェックリスト

- [ ] SQLインジェクションとプレースホルダの関係を説明できる。

- [ ] XSSの3種類(反射型、格納型、DOM Based)の違いがわかる。

- [ ] CSRF対策としてのトークンの仕組みを理解している。

- [ ] DASTとSASTの違いを説明できる。

- [ ] 診断ツールを使う際の注意点(許可、環境)を理解している。

- [ ] CVSSの基本評価基準の要素(AV、AC、PR、UI、S、C、I、A)を概説できる。